Aufbau und Nutzen eines AI-Servers mit Ollama und Web UI

Die rapide Entwicklung der künstlichen Intelligenz (KI) hat AI-Server zu einem unverzichtbaren Werkzeug gemacht, besonders in den Bereichen der Datenanalyse und des maschinellen Lernens. Mit Ollama und seiner benutzerfreundlichen Web UI wird der Einstieg und die Verwaltung solcher Systeme deutlich vereinfacht. Dieser Artikel beschreibt den Prozess des Aufbaus und der Konfiguration eines AI-Servers mit Ollama und zeigt auf, wie sowohl Unternehmen als auch Einzelpersonen von dieser Technologie profitieren können. Von Effizienzsteigerungen in der Wirtschaft bis zu innovativen Anwendungen in der Forschung – Ollama eröffnet neue Horizonte in der Nutzung künstlicher Intelligenz.

Grundlagen zu AI-Servern

AI-Server sind spezialisierte Rechner, die darauf ausgelegt sind, anspruchsvolle KI-Anwendungen zu betreiben. Sie unterscheiden sich von herkömmlichen Servern durch ihre Hardware-Konfigurationen, die oft leistungsstarke GPUs für das Training von Machine Learning-Modellen enthalten. Diese Server spielen eine entscheidende Rolle in der modernen Datenverarbeitung und KI-Forschung, indem sie komplexe Algorithmen effizient verarbeiten.

Was ist ein AI-Server?

Ein AI-Server ist ein dediziertes System, das speziell für Aufgaben im Bereich der künstlichen Intelligenz entwickelt wurde. Er ist mit High-End-Hardware ausgestattet, die darauf ausgelegt ist, große Mengen an Daten schnell zu verarbeiten und komplexe Berechnungen durchzuführen. Typischerweise beinhaltet diese Hardware mehrere CPUs und GPUs, umfangreiche Mengen an RAM und schnelle Speicherlösungen.

Wichtige Hardware-Komponenten

Die Leistung eines AI-Servers hängt maßgeblich von seinen Komponenten ab:

- GPUs (Graphics Processing Units): Diese sind essenziell für die Durchführung von parallelen Berechnungen, die bei KI-Prozessen wie dem Training von neuronalen Netzen benötigt werden.

- CPUs (Central Processing Units): Sie unterstützen die GPUs bei der Datenverarbeitung und übernehmen allgemeine Rechenaufgaben.

- RAM (Random Access Memory): Ein großer RAM-Speicher ermöglicht es, umfangreiche Datensätze schnell zu laden und zu bearbeiten, was für Echtzeitanwendungen entscheidend ist.

- Speicherlösungen: Schnelle SSDs (Solid-State Drives) oder sogar NVMe (Non-Volatile Memory Express) Speichermedien sorgen für schnelle Datenzugriffszeiten und effiziente Datenspeicherung.

Durch die Kombination dieser Komponenten können AI-Server komplexe KI-Modelle effizient trainieren und Inferenzoperationen mit hoher Geschwindigkeit durchführen. In der nächsten Sektion werden wir darauf eingehen, wie Ollama diese Hardwarekomponenten nutzt, um leistungsstarke AI-Serverlösungen zu bieten.

Einführung in Ollama und seine Web UI

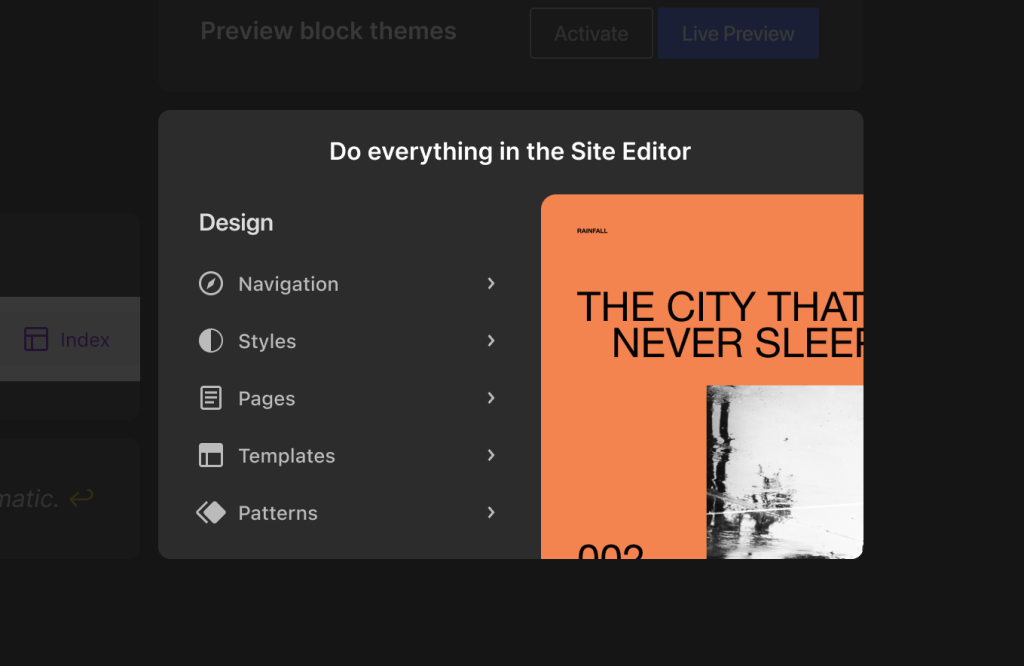

Ollama bietet eine revolutionäre Plattform für das Management und den Betrieb von AI-Servern, unterstützt durch eine intuitive Web-basierte Benutzeroberfläche. Die Web UI ermöglicht es Benutzern, ihre AI-Server effektiv zu steuern und zu überwachen, was die Komplexität der Verwaltung solch leistungsstarker Systeme erheblich reduziert.

Überblick über Ollama

Ollama ist nicht nur ein Werkzeug, sondern eine vollständige Lösung für das Hosting und die Verwaltung von KI-Anwendungen. Es bietet eine skalierbare Infrastruktur, die speziell darauf ausgerichtet ist, die Anforderungen von KI-Workloads zu erfüllen. Dies umfasst das Training von Modellen, das Verarbeiten großer Datenmengen und das Bereitstellen von Echtzeit-Inferenzen.

Vorteile der Web UI

Die Web UI von Ollama ist so gestaltet, dass sie auch für Nutzer ohne tiefgreifende technische Kenntnisse zugänglich ist. Zu den Hauptmerkmalen gehören:

- Benutzerfreundlichkeit: Eine klare und intuitive Benutzeroberfläche erleichtert die Navigation und die Durchführung komplexer Aufgaben.

- Monitoring: Echtzeit-Einblicke in die Leistung des Servers und laufende Prozesse helfen Benutzern, den Überblick zu behalten und proaktiv auf mögliche Probleme zu reagieren.

- Skalierbarkeit: Leichtes Hinzufügen oder Entfernen von Ressourcen je nach Bedarf, ohne die laufenden Operationen zu beeinträchtigen.

- Sicherheit: Fortgeschrittene Sicherheitsmaßnahmen schützen sensible Daten und Prozesse vor unbefugtem Zugriff und Bedrohungen.

Diese Kombination aus fortschrittlicher Technik und benutzerorientiertem Design macht Ollama zu einem unverzichtbaren Werkzeug für jeden, der AI-Server effizient und sicher betreiben möchte. Im nächsten Abschnitt werden wir detaillierter auf die verschiedenen Anwendungsszenarien von Ollama eingehen, sowohl im kommerziellen als auch im privaten Kontext.

Anwendungsszenarien für AI-Server

AI-Server wie Ollama finden in einer Vielzahl von Umgebungen Anwendung, von großen Unternehmen bis hin zu individuellen Forschungsprojekten. Die Fähigkeit, komplexe Daten schnell zu analysieren und darauf basierend Entscheidungen zu treffen, macht sie zu einem wertvollen Werkzeug in vielen Branchen.

Kommerzielle Nutzung

In der Geschäftswelt werden AI-Server für eine Reihe von kritischen Anwendungen eingesetzt:

- Datenanalyse: Unternehmen nutzen AI-Server, um große Datenmengen zu verarbeiten und daraus wertvolle Erkenntnisse zu gewinnen, die zur Strategieentwicklung und Entscheidungsfindung beitragen.

- Automatisierung: Viele repetitive und zeitintensive Aufgaben können automatisiert werden, was zu einer erheblichen Effizienzsteigerung führt.

- Kundenservice: AI-Server können dazu verwendet werden, Kundenservice-Bots zu betreiben, die Kundenanfragen schnell und präzise beantworten.

Private und akademische Nutzung

AI-Server sind nicht nur in der kommerziellen Landschaft nützlich, sondern auch in akademischen und privaten Szenarien:

- Forschung: Hochschulen und Forschungseinrichtungen nutzen AI-Server, um komplexe wissenschaftliche Probleme zu lösen, die intensive Datenanalyse und Modellierung erfordern.

- Persönliche Projekte: Technikenthusiasten und Entwickler setzen AI-Server ein, um eigene Projekte zu realisieren, von Lernanwendungen bis hin zu Heimautomatisierungssystemen.

Die Flexibilität und Leistung von Ollama ermöglichen es Benutzern in all diesen Szenarien, ihre Ziele effektiver zu erreichen und Innovationen voranzutreiben. Im folgenden Abschnitt werden wir die technischen Herausforderungen und Lösungsansätze beim Einsatz von AI-Servern wie Ollama detaillierter betrachten.

Anwendungsszenarien für AI-Server

AI-Server wie Ollama finden in einer Vielzahl von Umgebungen Anwendung, von großen Unternehmen bis hin zu individuellen Forschungsprojekten. Die Fähigkeit, komplexe Daten schnell zu analysieren und darauf basierend Entscheidungen zu treffen, macht sie zu einem wertvollen Werkzeug in vielen Branchen.

Kommerzielle Nutzung

In der Geschäftswelt werden AI-Server für eine Reihe von kritischen Anwendungen eingesetzt:

- Datenanalyse: Unternehmen nutzen AI-Server, um große Datenmengen zu verarbeiten und daraus wertvolle Erkenntnisse zu gewinnen, die zur Strategieentwicklung und Entscheidungsfindung beitragen.

- Automatisierung: Viele repetitive und zeitintensive Aufgaben können automatisiert werden, was zu einer erheblichen Effizienzsteigerung führt.

- Kundenservice: AI-Server können dazu verwendet werden, Kundenservice-Bots zu betreiben, die Kundenanfragen schnell und präzise beantworten.

Private und akademische Nutzung

AI-Server sind nicht nur in der kommerziellen Landschaft nützlich, sondern auch in akademischen und privaten Szenarien:

- Forschung: Hochschulen und Forschungseinrichtungen nutzen AI-Server, um komplexe wissenschaftliche Probleme zu lösen, die intensive Datenanalyse und Modellierung erfordern.

- Persönliche Projekte: Technikenthusiasten und Entwickler setzen AI-Server ein, um eigene Projekte zu realisieren, von Lernanwendungen bis hin zu Heimautomatisierungssystemen.

Die Flexibilität und Leistung von Ollama ermöglichen es Benutzern in all diesen Szenarien, ihre Ziele effektiver zu erreichen und Innovationen voranzutreiben. Im folgenden Abschnitt werden wir die technischen Herausforderungen und Lösungsansätze beim Einsatz von AI-Servern wie Ollama detaillierter betrachten.

Technische Herausforderungen und Lösungsansätze

Der Einsatz von AI-Servern wie Ollama bringt spezifische technische Herausforderungen mit sich, die sorgfältig angegangen werden müssen, um optimale Ergebnisse zu erzielen. Diese Herausforderungen umfassen Hardware-Anforderungen, Software-Kompatibilität und Netzwerkintegration.

Hardware-Anforderungen

- Leistungsbedarf: AI-Server benötigen leistungsfähige Hardware, insbesondere GPUs für das Training von KI-Modellen. Dies kann hohe Anfangsinvestitionen erfordern.

- Wärmeentwicklung: Hochleistungs-Hardware erzeugt viel Wärme. Effiziente Kühlsysteme sind entscheidend, um die Integrität und Leistung der Server zu gewährleisten.

Software-Kompatibilität

- Betriebssystem und Treiber: Die Kompatibilität zwischen dem Betriebssystem, den Treibern und der KI-Software muss gewährleistet sein, um Konflikte und Leistungseinbußen zu vermeiden.

- Updates und Wartung: Regelmäßige Updates sind notwendig, um Sicherheitslücken zu schließen und die Software auf dem neuesten Stand zu halten. Dies erfordert ein robustes Management-System.

Netzwerkintegration

- Bandbreitenanforderungen: AI-Server müssen oft große Datenmengen über das Netzwerk übertragen. Ausreichende Bandbreite ist essentiell, um Engpässe zu vermeiden.

- Sicherheit: Die Integration in bestehende Netzwerke bringt Sicherheitsherausforderungen mit sich, insbesondere bei sensiblen Daten.

Lösungsansätze

Um diese Herausforderungen zu bewältigen, bietet Ollama verschiedene technische Lösungen und Best Practices:

- Skalierbare Architektur: Ollama ermöglicht es, Ressourcen flexibel zu skalieren, um Leistungsanforderungen gerecht zu werden, ohne dabei die vorhandene Infrastruktur zu überfordern.

- Erweiterte Sicherheitsfeatures: Die Plattform implementiert mehrschichtige Sicherheitsmaßnahmen, um sowohl die Datenintegrität als auch die Netzwerksicherheit zu gewährleisten.

- Effizientes Ressourcenmanagement: Durch die Verwendung fortschrittlicher Algorithmen zur Ressourcenzuteilung und Lastverteilung maximiert Ollama die Effizienz der Hardware-Nutzung.

Durch das Verständnis dieser Herausforderungen und den Einsatz gezielter Lösungsstrategien können Unternehmen und Einzelpersonen die volle Leistungsfähigkeit von AI-Servern ausschöpfen, um ihre KI-gesteuerten Projekte erfolgreich umzusetzen. Im nächsten Abschnitt werden wir die Integration von AI-Servern wie Ollama in bestehende IT-Systeme weiter erörtern, um eine nahtlose und effiziente Einbindung zu gewährleisten.

Integration in bestehende IT-Systeme

Die erfolgreiche Integration von AI-Servern wie Ollama in bestehende IT-Infrastrukturen stellt eine Herausforderung dar, die jedoch mit strategischer Planung und den richtigen Werkzeugen effektiv gemeistert werden kann.

Kompatibilität und Vernetzung

- Systemkompatibilität: Die Gewährleistung der Kompatibilität zwischen Ollama und bestehenden Systemen ist entscheidend. Dies umfasst die Software-Integration sowie die Hardware-Anforderungen, um Konflikte zu vermeiden und eine nahtlose Funktionalität zu sichern.

- Netzwerkanbindung: AI-Server müssen oft in bestehende Netzwerkstrukturen eingebunden werden. Hierbei ist es wichtig, dass die Netzwerktopologie und ‑sicherheit auf die hohen Datenlasten und Sicherheitsanforderungen der KI-Anwendungen abgestimmt sind.

Fallbeispiele und Anwendungsberichte

- Branchenlösungen: Verschiedene Industriezweige wie die Finanzbranche, das Gesundheitswesen und der Einzelhandel haben spezifische Anforderungen, die bei der Integration von AI-Servern berücksichtigt werden müssen. Anhand von Fallbeispielen lässt sich zeigen, wie Ollama erfolgreich in solche Umgebungen integriert wurde.

- Anpassung an Unternehmensgröße: Die Skalierbarkeit von Ollama ermöglicht die Anpassung an die Bedürfnisse von kleinen, mittleren und großen Unternehmen. Praxisbeispiele illustrieren, wie Unternehmen verschiedener Größen Ollama effektiv nutzen, um ihre KI-gesteuerten Projekte zu unterstützen.

Best Practices für die Implementierung

- Sicherheitsstrategien: Da Sicherheit bei der Integration von AI-Servern eine große Rolle spielt, sollten fortgeschrittene Sicherheitsprotokolle und ‑praktiken implementiert werden. Dazu gehören die Verschlüsselung von Daten, die Verwendung von VPNs und regelmäßige Sicherheitsaudits.

- Datenmanagement: Effektives Datenmanagement ist entscheidend, um die Leistungsfähigkeit von AI-Servern zu maximieren. Dies beinhaltet die Optimierung der Datenspeicherung und ‑zugriffe sowie die Implementierung von Datenredundanz und ‑backup-Lösungen.

Die Integration von AI-Servern in bestehende IT-Systeme erfordert nicht nur technisches Know-how, sondern auch ein tiefes Verständnis für die spezifischen Bedürfnisse und Herausforderungen der jeweiligen Organisation. Im nächsten Abschnitt werden wir die rechtlichen und ethischen Überlegungen betrachten, die beim Einsatz von AI-Servern wie Ollama zu berücksichtigen sind.

Rechtliche und ethische Überlegungen

Die Nutzung von AI-Servern wie Ollama bringt eine Reihe von rechtlichen und ethischen Fragen mit sich, die sorgfältig erwogen werden müssen. Diese umfassen den Datenschutz, die Datensicherheit und die ethischen Implikationen des Einsatzes künstlicher Intelligenz.

Datenschutz und Compliance

- Datenschutzbestimmungen: In vielen Ländern, einschließlich der EU mit der Datenschutz-Grundverordnung (DSGVO), sind strenge Regelungen zum Schutz personenbezogener Daten in Kraft. AI-Server müssen diese Bestimmungen einhalten, was die Implementierung von umfassenden Datenschutzmechanismen erfordert.

- Compliance-Anforderungen: Je nach Branche können zusätzliche Compliance-Anforderungen gelten, wie HIPAA im Gesundheitswesen in den USA oder GDPR in Europa, die spezifische Anforderungen an die Datenverarbeitung und ‑sicherheit stellen.

Ethische Aspekte

- Transparenz und Fairness: Der Einsatz von KI muss transparent gestaltet sein, um Vertrauen bei den Nutzern zu schaffen. Zudem ist auf die Fairness der KI-Algorithmen zu achten, um Verzerrungen und Diskriminierungen zu vermeiden.

- Verantwortung: Die Frage der Verantwortlichkeit bei Fehlentscheidungen von KI-Systemen ist ein zentrales ethisches Problem. Es muss klar definiert werden, wer in solchen Fällen haftbar ist – der Betreiber des AI-Servers, der Entwickler der KI-Software oder beide.

Best Practices für ethische KI

- Ethik-Leitlinien: Viele Organisationen implementieren Ethik-Leitlinien für den Einsatz von KI, um sicherzustellen, dass ihre Technologien verantwortungsvoll und im Einklang mit gesellschaftlichen Werten genutzt werden.

- Ständige Überwachung und Bewertung: Die fortlaufende Überwachung der KI-Systeme hilft, unerwünschte Verhaltensweisen frühzeitig zu erkennen und zu korrigieren.

Durch die Beachtung dieser rechtlichen und ethischen Überlegungen können Organisationen sicherstellen, dass ihre AI-Server nicht nur effektiv, sondern auch verantwortungsvoll eingesetzt werden. Im nächsten Abschnitt fassen wir die Schlüsselpunkte zusammen und blicken auf die Zukunft der AI-Server-Technologie.

Fazit und Ausblick

In diesem Artikel haben wir die vielseitigen Anwendungsmöglichkeiten von AI-Servern wie Ollama und die Funktionalitäten seiner Web UI detailliert betrachtet. Von der technischen Implementierung über die Integration in bestehende Systeme bis hin zu den rechtlichen und ethischen Herausforderungen bietet Ollama eine robuste Plattform für die effiziente Nutzung von KI-Technologien.

Zusammenfassung der Schlüsselelemente

- Technische Exzellenz: Ollama unterstützt durch seine leistungsstarke Hardware und anpassbare Web UI die Durchführung komplexer KI-Operationen.

- Flexibilität: Ob in kommerziellen Unternehmen, akademischen Einrichtungen oder für private Projekte, Ollama passt sich verschiedenen Anforderungen an.

- Benutzerfreundlichkeit: Die intuitive Web UI macht es auch weniger technisch versierten Nutzern möglich, von den Vorteilen der KI zu profitieren.

Zukünftige Entwicklungen

- Weiterentwicklung der KI-Technologien: Wir erwarten kontinuierliche Verbesserungen in der Leistungsfähigkeit und Effizienz von KI-Servern, die neue Anwendungsfelder eröffnen werden.

- Erhöhung der Sicherheitsstandards: Mit der zunehmenden Verbreitung von KI-Servern wird auch die Entwicklung fortgeschrittener Sicherheitslösungen voranschreiten, um Daten besser zu schützen und Compliance zu gewährleisten.

- Demokratisierung der KI-Nutzung: Durch weitere Vereinfachungen in der Bedienung und günstigere Kostenstrukturen wird KI-Technologie einer breiteren Masse zugänglich gemacht.

Die Welt der KI ist dynamisch und ständig im Wandel. Plattformen wie Ollama sind an der Spitze dieser Entwicklung und ermöglichen es uns, das Potenzial der KI voll auszuschöpfen und innovative Lösungen für komplexe Probleme zu entwickeln. Mit der richtigen Vorbereitung und den notwendigen Tools können AI-Server eine zentrale Rolle in der Gestaltung unserer technologischen Zukunft spielen.

FAQs

Was sind die Hauptvorteile eines AI-Servers mit Ollama und Web UI?

AI-Server mit Ollama bieten hohe Rechenleistung für KI-Anwendungen, effiziente Datenverarbeitung und die Fähigkeit, komplexe Modelle zu trainieren. Die Web UI ermöglicht eine einfache Bedienung und Verwaltung des Servers, was die Zugänglichkeit für Benutzer ohne tiefgreifende technische Kenntnisse erhöht.

Wie unterscheidet sich ein AI-Server von einem herkömmlichen Server?

Ein AI-Server ist speziell für Aufgaben der künstlichen Intelligenz optimiert und verfügt über leistungsstarke Hardware wie GPUs, die speziell für das Training und die Ausführung von KI-Modellen entwickelt wurden. Herkömmliche Server sind eher auf allgemeine Datenverarbeitungs- und Netzwerkaufgaben ausgerichtet.

Welche Sicherheitsmaßnahmen sollten bei der Nutzung von AI-Servern wie Ollama berücksichtigt werden?

Wichtige Sicherheitsmaßnahmen umfassen die Implementierung von Datenverschlüsselung, regelmäßige Sicherheitsupdates und ‑audits, die Nutzung von sicheren Netzwerkverbindungen und den Einsatz von Firewalls und Antivirensoftware, um das System vor externen Bedrohungen zu schützen.

Kann ich Ollama auf einem vorhandenen Server installieren oder benötige ich spezielle Hardware?

Ollama kann auf vorhandenen Servern installiert werden, sofern diese die Hardware-Anforderungen erfüllen, die für die gewünschten KI-Anwendungen notwendig sind. Dies beinhaltet in der Regel leistungsstarke GPUs, ausreichend RAM und schnelle Prozessoren.

Wie kann ich die Leistung meines AI-Servers mit Ollama optimieren?

Die Leistung eines AI-Servers kann durch die Optimierung der Hardware-Konfiguration, die regelmäßige Aktualisierung der Software und das Feintuning der Netzwerkeinstellungen verbessert werden. Außerdem ist es wichtig, die Ressourcennutzung kontinuierlich zu überwachen und Anpassungen vorzunehmen, um Engpässe zu vermeiden und die Effizienz zu maximieren.

Rückmeldungen